Subdifferential

Das Subdifferential ist eine Verallgemeinerung des Gradienten auf nicht differenzierbare konvexe Funktionen. Das Subdifferential spielt eine wichtige Rolle in der konvexen Analysis sowie der konvexen Optimierung.

Definition

Sei

eine konvexe Funktion. Ein Vektor

heißt Subgradient von

an der Stelle

,

wenn für alle

gilt

,

wobei

das Standardskalarprodukt

bezeichnet.

Das Subdifferential

ist die Menge aller Subgradienten von

im Punkt

.

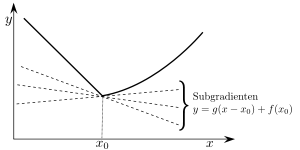

Anschauung

Intuitiv bedeutet diese Definition für ,

dass der Graph der Funktion

überall über der Geraden

liegt, die durch den Punkt

geht und die Steigung

besitzt:

Da die Normalengleichung

von

gerade

ist, ist die Normale an

also

Im allgemeinen Fall

liegt

über der Hyperebenen, die durch den

Fußpunkt

und die Normale

gegeben ist.

Wegen des Trennungssatzes ist das Subdifferential einer stetigen konvexen Funktion überall nicht leer.

Beispiel

Das Subdifferential der Funktion ,

ist gegeben durch:

Beschränktheit

Sei

stetig und sei

beschränkt. Dann ist die Menge

beschränkt.

Beweis

Sei

stetig und sei

beschränkt. Setze

wobei

.

Angenommen

ist nicht beschränkt, dann gibt es für

ein

und ein

mit

.

Sei

.

Somit sind

.

Wir erhalten die Abschätzung

.

ist also kein Subgradient. Das ist ein Widerspruch.

© biancahoegel.de

Datum der letzten Änderung: Jena, den: 07.01. 2022